Author: Mark Sandler, Andrew G. Howard, Menglong Zhu, Andrey Zhmoginov, Liang-Chieh Chen

Date: Jan 13, 2018

URL: https://arxiv.org/abs/1801.04381

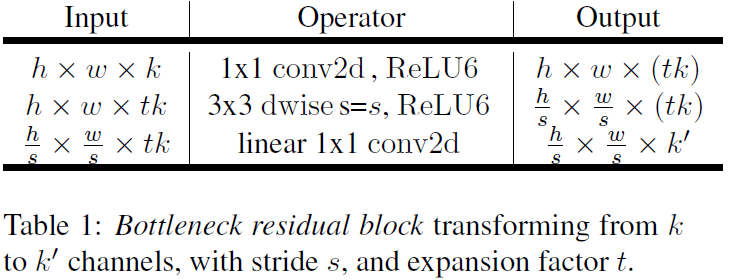

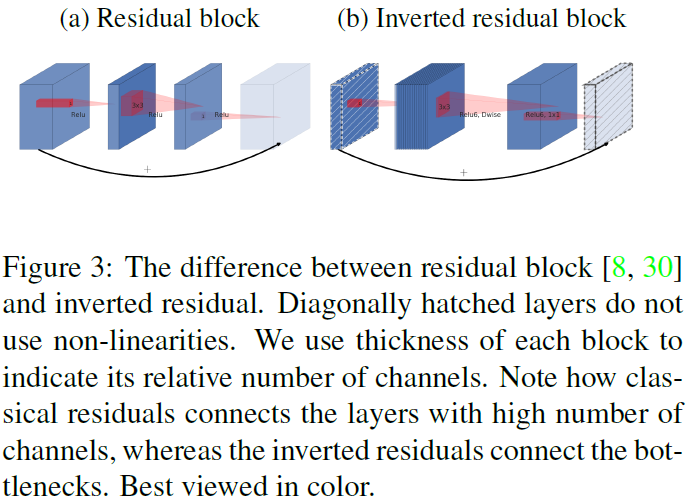

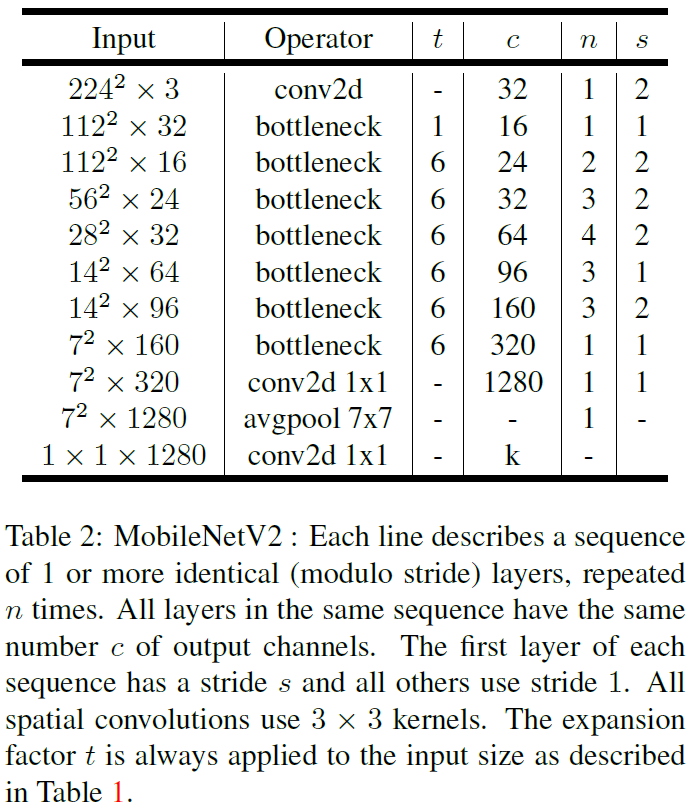

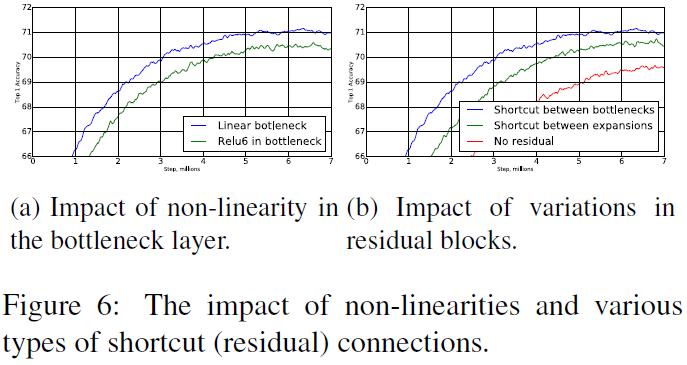

Depthwise Separable Convolution, Linear Bottlenecks, Inverted Residuals.width multiplier parameter를 사용.