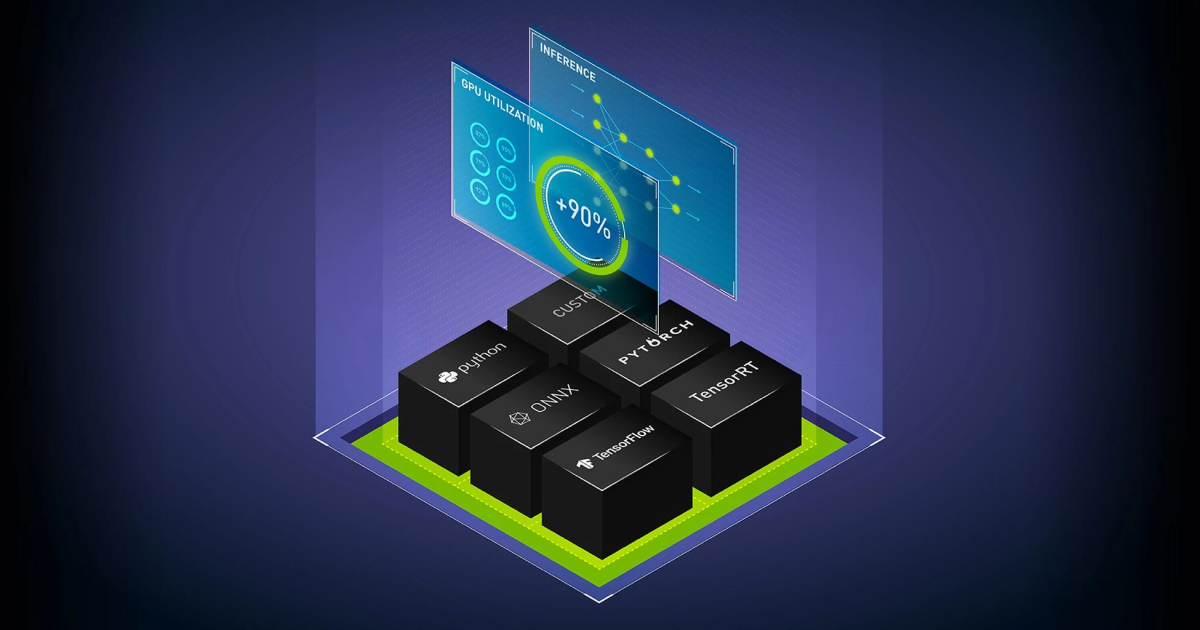

저번 포스팅(Triton Inference Server 입문기 - (1))과 이어집니다!

이번 포스팅에선 Triton Inference Server를 직접 실행시켜보고자 합니다!

예제 레포는 여기입니다! https://github.com/jjerry-k/triton_sample

그럼 레포 구성 > ML/DL 모델 > 클라이언트 API 순으로 설명을 해보겠습니다!

(설명이 필요 없고 실행부터 해보고 싶으시면….레포의 README 참고…)

triton_sample

├── api

├── model_repository

├── docker-compose.yml

├── README.md

├── test_image

└── test_run.py

api

model_repository

Etc